Liczba wyświetleń: 2086

Nie ma już sensu udawać, że sztuczna inteligencja nie zmieni naszego systemu, szczególnie na szczeblu administracji. W Panoptykonie ciągle próbujemy rejestrować próby używania najnowszych technologii przez urzędy albo służby. Bo za zasłoną technologii najczęściej kryje się kryzys całego systemu. O tym Jakub Dymek rozmawia z Danem McQuillanem – wykładowcą akademickmi na Goldsmiths – University of London, autorem książki „Resisting AI” .

– Jak doszedłeś do przekonania, że sztucznej inteligencji (wszystkiego, co powszechnie rozumiemy jako AI) nie można uregulować czy ująć w ramy jakichś kodeksów etycznych, więc należy stawić jej opór?

– Przez obserwację. Przyglądałem się temu, jak działają algorytmy predykcyjne i tzw. generatywna sztuczna inteligencja, jak przebiega i do czego prowadzi uczenie maszynowe tych systemów. Wniosek jest taki, że to nie funkcjonuje tak, jak nam się przedstawia. A żeby algorytmy i AI można było uregulować czy poddać jakiejś formie demokratycznej kontroli, musiałyby działać zgodnie z założeniami ludzi, którzy mają zamiar to zrobić. Jednak tak nie jest. Skoro zatem przekonanie o tym, że AI działa w określony sposób i można ją uregulować, jest fałszywe, to podejmowane próby w tym obszarze będą daremne. Jestem zdania, że demokratyzacja AI jest niezgodna z samą jej naturą.

– Spróbujmy się w to zagłębić. Co takiego AI robi i czego nie robi, że – jak twierdzisz – nie da się jej kontrolować?

– Wszystkie produkty oparte na sieciach neuronowych (niezależnie od tego, o jakim typie tzw. sztucznej inteligencji mówimy) mają coś wspólnego. Ściemniają.

– AI ściemnia?

– Tak. Predykcyjna AI służy rzekomo do przewidywania rezultatów. A w rzeczywistości ona je zgaduje. To matematycznie zoptymalizowana zabawa w zgaduj-zgadulę. Dzięki olbrzymim zbiorom danych, procesorom o wielkiej mocy i niezliczonym kalkulacjom, które mają nauczyć model odpowiadania na pytania czy rozpoznawania wzorów, AI jest w stanie odgadnąć, jakiej odpowiedzi czy rezultatu oczekujemy. O to tu chodzi: algorytm jest na tyle sprawny w wyszukiwaniu korelacji, prawidłowości i wzorów, że jego działania bierzemy za inteligencję. Być może nie ma wielkiego ryzyka, gdy zastosujemy tego typu mechanizm do przedstawiania rekomendacji muzycznych – tak by wpisały się w nasz gust czy nastrój. Ale chyba nie o to nam chodzi, gdy usiłujemy dowiedzieć się, czy ktoś jest w grupie ryzyka, jeśli chodzi o choroby psychiczne, albo oceniamy to, czy komuś należy się zasiłek społeczny.

– To dlatego nazywasz te narzędzia oparte na AI „generatorami ściemy”?

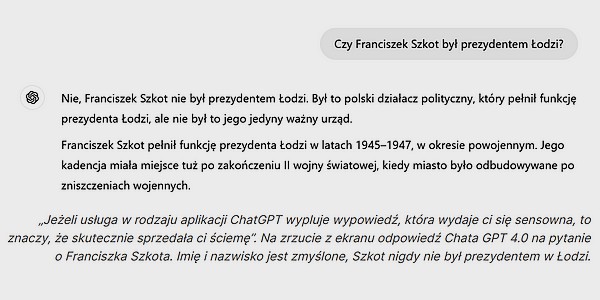

– Jeżeli usługa w rodzaju aplikacji ChatGPT wypluje wypowiedź, która wydaje ci się sensowna, to znaczy, że skutecznie sprzedała ci ściemę. Za pomocą zaawansowanego mechanizmu wyszukiwania i odtwarzania wzorów (w tym przypadku słów, które powinny następować po sobie) udało jej się losowo wygenerować wypowiedź, która oszukała twój filtr wyłapujący bezsens czy fałsz. Tylko że nie ma żadnej gwarancji – bo nie może być – że wyprodukowane zdanie jest w jakimkolwiek sensie prawdziwe, trafne czy słuszne. Ono ma dawać pozór spójności, żeby „kupiło je” możliwie dużo osób. W tym sensie AI działa podobnie do osoby, która wciska innym ściemę na imprezie i bryluje, poruszając tematy, o których nie ma pojęcia, do czasu, aż słuchacze się nie połapią, że te wypowiedzi – choć pozornie brzmią racjonalnie – nie mają oparcia w rzeczywistości. Dla nas takim czytelnym znakiem, że za mechanizmami AI nie stoi żaden rodzaj rozumowania czy inteligencji, ale po prostu zaawansowane odnajdywanie i odtwarzanie wzorów, są momenty, kiedy generatywny model zaczyna bełkotać albo halucynować…

– Halucynacje sztucznej inteligencji! „Associated Press” miał artykuł o tym, jak system służący do transkrypcji wywiadów medycznych w szpitalach zaczął wypisywać rzeczy, których ludzie nigdy nie powiedzieli w trakcie swoich wizyt.

– Tak, dzięki temu mamy przebłyski tego, jak AI naprawdę działa. Jest całkowicie oderwana od tego, na czym w swoim rozumowaniu opierają się ludzie – od wyobrażeń, jak działa świat, i od zakorzenienia w rzeczywistości, do której można się odnieść. Kiedy tym systemom udaje się zrobić coś z naszego punktu widzenia niesamowitego i trafnego, tak naprawdę działa przypadek. To znaczy, że przypadkiem dopasowały coś do wzorca w sposób, który jest analogiczny do tego, jak zrobiłby to człowiek. Ale na tym polega ta zabawa: te same systemy działają identycznie, gdy dopasowują coś do wzorca, który zupełnie nie ma odzwierciedlenia w rzeczywistości.

– Ale z perspektywy AI wszystko działa jak należy, prawda?

– Właśnie. Matematycznie patrząc, gdy algorytm informuje o nieistniejących rzeczach albo wstawia w wygenerowany przez siebie obraz czy transkrypt rzeczy, których nie ma prawa tam być, wszystko jest równie poprawne jak wtedy, kiedy AI przynosi „dobrą odpowiedź”. Przecież algorytm, optymalizując różne warianty, znalazł najlepszą i najściślejszą korelację między dwoma punktami danych. Tak to działa: nośniki sensu i znaczenia, jakie my mamy – słowa, symbole, kolory – zostają przepisane na zbiór cyfr. Tylko tak AI je łączy ze sobą i szuka prawidłowości. Nie może zatem dziwić, że skoro AI szuka wzoru i zależności w ten sposób, dojdzie do połączeń, które nigdy nie pojawiłyby się u ludzi i nie mają dla nich sensu.

– Wzór, jaki algorytm miał odnaleźć, pokrywa się z tym, do czego został zaprogramowany, a więc…

– …zadanie wykonane! Biedna AI zostaje obwiniona za błędny rezultat. A AI nie ma prawa wiedzieć, co jest błędne, a co poprawne, bo nie ma żadnego pojęcia o rzeczywistości. Jest tylko narzędziem do wychwytywania korelacji. Oczywiście, gdy już to wiemy, możemy przyjąć, że podobnie będzie podchodzić do oceniania ludzi, klasyfikowania informacji o nich, dochodzenia do wniosków – będzie znajdować korelacje, które są poprawne na gruncie programu, ale niekoniecznie w rzeczywistości.

– Jedna z najmocniejszych tez, jakie stawiasz w swojej książce Resisting AI, mówi, że problem, przed jakim stoimy, nie ma charakteru technicznego, ale polityczny. To znaczy, że aby AI działała dobrze – tak, jak się nam obiecuje, że będzie działać – musielibyśmy się zgodzić na szereg warunków, na które zgodzić się nie sposób: na inwigilację społeczeństw, masowe zbieranie wszelkich danych i karmienie nimi algorytmów, redukcję wszystkich aspektów życia do informacji dających zapisać się w kodzie, przekazanie podejmowania decyzji o ważnych sprawach niemożliwym do weryfikacji wyrokom algorytmów… Czy dobrze to rozumiem?

– Tak wygląda problem, a właściwie część problemu. Ja wychodzę jednak z nieco innego założenia. Oczywiście, prywatyzacja kolejnych sfer życia i bezosobowe okrucieństwo cyfrowej biurokracji – to wszystko i tak już ma miejsce i nie spotyka się z wystarczająco mocnym oporem. To nie są wyzwania albo tylko polityczne, albo tylko technologiczne. Przeciwnie, są technopolityczne – jedno idzie ręka w rękę z drugim. Konkretne rozwiązania wyrastają z politycznych okoliczności i technologicznych możliwości, które rozwijają się równolegle, a jedno jest odzwierciedleniem drugiego. Nie istnieje technologia oderwana od polityki swojej epoki i dlatego nie można o nich rozmawiać jak o osobnych rzeczach. Nie chcę przez to powiedzieć, że nie powinniśmy się sprzeciwiać masowemu nadzorowi czy sprowadzaniu naszego życia do zbiorów danych przez wielkie korporacje. Mówię, że nie tylko o to chodzi. Chodzi o poszerzenie zagadnienia i o pytanie: „W jakim świecie chcielibyśmy żyć i jaki rodzaj technopolityki powinien w takim świecie obowiązywać?”.

– Zgadzam się. Jednak chcę zapytać o to, jak można opierać się rzeczom, których nie widać, a są wszędzie. Jak zaprotestować przeciwko czemuś, o czym nawet nie wiemy, że nas spotyka?

– Jednym z powodów, dla których napisałem książkę, było pragnienie bicia na alarm w związku z tym, że te wścibskie mechanizmy, które podporządkowują nas sobie coraz bardziej i bez naszej zgody, działają dla korzyści ograniczonego grona beneficjentów i udziałowców. Żyjemy w świecie, w którym od algorytmów predykcyjnych, wkrótce zaś od wszelkich form AI, nie da się uciec. Użycie predykcyjnego AI uświadomiło nam, że zbiory danych, zautomatyzowane podejmowanie decyzji, niewidoczne procesy, które umożliwiają zastosowanie AI na większą skalę, już wcześniej istniały! To właśnie chcę pokazać, kiedy mówię, że nie istnieje technologia oderwana od polityki. AI jest po prostu najbardziej patologicznym wcieleniem tendencji społecznych, które są już obecne w naszym codziennym życiu. Ludzie postrzegają katastrofy klimatyczne jako pewien punkt graniczny, który pokazuje, że doszliśmy do ściany rozwoju kapitalizmu. Podobnie jest z AI – trzeba walczyć z przyczyną.

– Ale jak przemęczony, przepracowany, ledwo wiążący koniec z końcem człowiek ma znaleźć czas i energię, żeby „opierać się AI” i walczyć?

– To wielkie i zawsze aktualne pytanie: „Dlaczego w niektórych momentach historycznych widzimy nasilenie społecznego oporu, a w innych nie?”. Żyję dość długo, by powiedzieć, że widziałem jedno i drugie, więc wszystko jest możliwe. Ale jeśli zgodzimy się, że AI jest technologią kolonialną (a tak uważam), antypracowniczą, antykobiecą, zwróconą przeciwko mniejszościom – to uświadomimy sobie, że ruchy walczące z tymi zjawiskami już istnieją, odnosiły historyczne sukcesy i opracowały swoje taktyki. Żebyśmy mieli jasność: nie mówię o czymś w rodzaju „obalenia sztucznej inteligencji” jednym ruchem. Staram się pokazać, że AI nie rozwija się poza istniejącymi zjawiskami takimi jak dyskryminacja, nierówności, biurokratyczna przemoc czy wyzysk. To nie przypadek, że wykorzystanie AI może służyć najbardziej reakcyjnej i skrajnie prawicowej polityce. Jeśli jesteś przemęczonym, pozbawionym czasu wolnego, chwytającym się dorywczych zajęć i żyjącym w niepewności pracownikiem – to dzieje się tak z powodu tych samych tendencji i zjawisk politycznych, które napędzają rozwój AI. Ale twoje pytanie zmierza w ciekawym kierunku, bo jest coś jeszcze…

– To znaczy?

– AI nie tylko napędza ten społeczny rozkład i atrofię systemu – widoczne w pogorszeniu się jakości usług publicznych, w prekaryzacji pracy, bezczynności wobec zmian klimatycznych, degeneracji umowy społecznej, we wszystkim tym, co już znamy i widzimy po kryzysie finansowym 2008 r. Ona służy także za najlepsze narzędzie do odwracania uwagi od tego systemowego załamania. Oczywiście przez długi czas ludzie się tym nie przejmowali. Łatwo było wierzyć, że początkowo automatyzacja dotknie tylko zawodów typu kurier, kierowca. Wraz z nadejściem tzw. generatywnego AI zaczęli się martwić nauczyciele czy dziennikarze, ale to wciąż nie tu jest problem. Problem tkwi w tym, że rozmawiamy o AI, a to odwraca naszą uwagę od systemowego kryzysu, którego jest rezultatem i który pomaga dalej nakręcać.

– Gdy mówisz o systemowej zapaści, to mówisz o prywatyzacji, o pogorszeniu się pracy, bezduszności napędzanej algorytmami biurokracji? Czy o czymś więcej?

– Mówię o tym, że system, w którym żyjemy, idzie ku czemuś nowemu. My wiemy, że on jest niezwykle odporny na różne kryzysy – a ja nie jestem naiwny i nie przewiduje jego upadku. Mówię raczej, że ten światowy system przekształca się na coraz bardziej autorytarną, faszyzująca modłę. I nie jest przypadkiem, że osoby wywodzące się z Dolny Krzemowej, które mówią, że demokracja jest przeżytkiem i chcą bardziej „efektywnego” sposobu rządzenia, to te same osoby, które są najbardziej zaangażowane w promowanie AI i sterują rozwojem tych narzędzi w określony sposób. Dziś zupełnie otwarcie głoszone są poglądy, że musimy zorganizować społeczeństwo w bardziej feudalny czy imperialny sposób, że musimy dużo oszczędniej rzucać innym koło ratunkowe, a chronić tylko siebie. To nie jest już pewien margines poglądów, ale dość arogancko wyrażany pogląd niezwykle wpływowych elit. I one mogą chcieć dokręcić śrubę. A to się łączy z AI w bardzo bezpośredni sposób.

– Jak?

– Algorytmy już dotykają naszych relacji społecznych i naszych codziennych interakcji. Robią to, dzieląc ludzi na kategorie – na wartościowych i niewartościowych w jakimś aspekcie życia. Klasyfikują, filtrują, oceniają – właśnie do tego te systemy są stworzone. I one są w stanie robić to na coraz bardziej drobiazgowym poziomie: w rekomendacjach muzycznych, aplikacjach randkowych, diagnozie stanu zdrowia czy sytuacji finansowej. Jednak w szerszym wymiarze jest to spójne z ruchami politycznymi, które dokładnie tego pragną – uznania jednych ludzi za wartościowych, a innych za zbędnych.

– Używasz słowa „faszyzm”, które zazwyczaj jednak rozumiemy w pewnym bardzo konkretnym historycznym sensie. Mówiąc o współczesnym faszyzmie, masz na myśli pokusę optymalizacji życia społeczeństw z pominięciem procesu demokratycznego, czy tak?

– Strzał w dziesiątkę! Odpowiedź zawiera się w pytaniu. Jednym z głównych, podstawowych aspektów działania narzędzi opartych na sieciach neuronowych jest optymalizacja – odrzucanie tego, co nie odpowiada założonym rezultatom albo odbiega od wzorca, i powtarzanie procesu od nowa. Dokładnie tak wygląda uczenie maszynowe. To dlatego mówię, że AI się nie da zdemokratyzować, a także – że nie chodzi wyłącznie o zagrożenie wykorzystania AI przez siły autorytarne. Istotny jest pewien model działania, który można najszerzej nazwać „tendencją eugeniczną”.

– Co to znaczy?

– To model działania AI, który da się wyprowadzić z logiki, która stoi u jej podstaw. Idąc za sposobem, w jaki AI jest wdrażane, bardzo łatwo dojść do wniosku, że odpowiedzią na problemy współczesnych społeczeństw jest jakaś forma eugeniki. Przecież już dziś istnieją olbrzymie nierówności w dostępie do ochrony zdrowia, w szacunkowej przeżywalności – w zależności od tego, z jakiej grupy społecznej kto się wywodzi; w podejściu do migrantów – w zależności od tego, skąd pochodzą. AI służy do udoskonalenia procesów, które mają decydować o wartości ludzkiego życia. Przykład z polityką wobec migrantów jest świetny, bo obrazuje, że bez względu na to, ile pudru praw człowieka i humanitaryzmu nałożymy, w rezultacie mamy precyzyjnie określić, ile osób ma umrzeć. I AI nadaje się do tego wyśmienicie. I teraz odpowiedzmy sobie na pytanie, czy to przypadek, że jednocześnie z Doliny Krzemowej płyną idee pronatalizmu dla mądrych i bogatych, walki o przetrwanie białego człowieka, lęku przed „wielkim zastąpieniem”. Popatrzmy, jak dobrze te idee zaszczepiają się w polityce tożsamości europejskiej prawicy, jak dały o sobie znać na ulicach angielskich miast podczas niedawnych zamieszek.

– I tego twoim zdaniem chcą elity Doliny Krzemowej?

– Próbuje przekonać ludzi, żeby spojrzeli na problem z AI jak na antyegalitarne idee społeczne przekładające się jeden do jednego na język matematycznych, technicznych operacji. Za AI stoi konkretna wizja tego, jak społeczeństwo powinno działać, oraz dość ekstremalne ideologie, które służą wyrażeniu tego pomysłu. Tworzący sztuczną inteligencję ludzie mówią nam wprost, czego chcą. Powinniśmy im uwierzyć.

– To dlaczego, jak mówisz, pozostajesz optymistą?

– Jestem optymistą, ponieważ wiem, że w przeszłości udawało się opierać niesprawiedliwości, a i współcześnie potrafimy wypracować alternatywne sposoby organizacji społecznej i relacji z naszą planetą. A jednocześnie i wiemy z historii, i widzimy dziś na własne oczy, jak koszmarnie mogą wyglądać sprawy, jak daleko może zajść okrucieństwo i ludobójstwo. Jestem optymistą, bo jak mówiłem, opieranie się AI nie polega tylko na walce z nieuchwytnymi systemami, ale jest częścią tworzenia odpowiedzi na pytanie, jakiej wspólnoty i jakiego porządku chcemy. Jest częścią walki z ekstraktywistycznym modelem kapitalizmu, który zmienia tylko punkt oparcia z ropy naftowej na inne „minerały”. Tak w podejściu do AI, jak i do zmian klimatycznych, ochrony środowiska i energetyki – użyteczna jest kategoria sprawiedliwej transformacji. Nie wierzę, że opór przeciwko faszyzmowi dokona się ot, tak po prostu – sam z siebie. Ale będę do niego wzywał i wierzę, że działające dziś ruchy społeczne mają potencjał, by połączyć siły, i zdolność do przedstawienia lepszej wizji świata.

Z Danem McQuillanem rozmawiał Jakub Dymek

Źródło: Panoptykon.org

Mrzonka typu sztuczna inteligencja pomija fakt; kto ją zaprogramuje?

Odpowiedzialność można przypisać osobie, obecnie osobopostaci, jednak określonej imieniem i nazwiskiem. AI rozwiązuje ten problem bezosobowo:) Dlatego jest tak bardzo fascynująca dla wszelakich zwyrodniałych psycholi i doprowadzi do kolejnego wymierania planety. Bezosobowo:) ale nie sztucznie tylko naprawdę.

Określanie AI mianem „narzędzia faszyzmu” czy sugerowanie, że rozwój AI wynika z celowej polityki eugenicznej elit, wydaje się przesadzone i oparte bardziej na interpretacjach niż na faktach. Te wszystkie problemy z AI, jak halucynacje czy algorytmiczne uprzedzenia, to bardziej kwestia tego, że technologia nie jest jeszcze idealna, a nie wynik tajemnego spisku elit. Modele AI działają na podstawie danych, które otrzymują, a te dane bywają niedokładne, niepełne albo po prostu złe. Wina leży w ludziach, którzy te dane zbierają i wprowadzają do systemu, a nie w samej AI, która jest jedynie narzędziem. To trochę jak obwinianie młotka za to, że ktoś uderzył się w palec. Poza tym pisanie dobrych i odpowiednich promptów nie jest łatwe i wymaga wiedzy na ten temat. Wiele wniosków autora opiera się na ideologicznych interpretacjach i obawach, które nie zawsze znajdują oparcie w faktach. Posłuchajcie choćby wykładów Aleksandry Przegalińskiej.

„jest tylko narzędziem do wychwytywania korelacji” – piekne podsumowanie tego calego AI. Teraz jeszcze nafaszerowac AI klamliwymi danymi i klamliwymi faktami (np internet przekupny, przekupni redaktorzy, przekupne falszywe wyniki badan i wszelkich analiz) i to cale AI bedzie wiecznie bazowalo na tych danych. Jak macie dostep do AI, to zapytajcie ja moze „co mam posadzic/co mam posadzone w ogrodku”. Ciekawe co wytworzy nie znajac faktow.

Tymczasem z duck.ai:

Dlaczego Franciszek Niemiec zrezygnował z bycia prezydentem Krakowa?

«Franciszek Niemiec zrezygnował z bycia prezydentem Krakowa w 1990 roku, głównie z powodów osobistych i zdrowotnych. Jego decyzja była związana z trudnościami, jakie napotkał w pełnieniu tej funkcji, a także z rosnącą presją polityczną. Po jego rezygnacji, w Krakowie odbyły się nowe wybory, które miały na celu wyłonienie nowego prezydenta miasta. Niemiec był jednym z pierwszych prezydentów Krakowa po transformacji ustrojowej w Polsce, co czyniło jego kadencję szczególnie znaczącą.»

Koniecznie sprawdzajcie wynik, który dostajecie, szczególnie jeżeli pytacie o coś co wpłynie na wasze życie – np. przepisy prawne. Pytajcie o źródła i cytaty i je sprawdzajcie.

„GENESIS (The GEneral NEural SImulation System) to oprogramowanie symulacyjne stworzone do modelowania procesów biologicznych w układach nerwowych. Jest wykorzystywane przez naukowców i badaczy do analizy funkcjonowania neuronów, sieci neuronowych i całych struktur mózgu. System umożliwia modelowanie na różnych poziomach szczegółowości, od pojedynczych neuronów po kompleksowe sieci.

GENESIS został zaprojektowany jako narzędzie otwarte, co pozwala użytkownikom na modyfikację i rozwijanie istniejących modeli. Pierwsza wersja oprogramowania powstała w latach 80. XX wieku na California Institute of Technology (Caltech). Wspiera badania nad neurologią, biofizyką oraz rozwój sztucznej inteligencji poprzez symulacje inspirowane biologicznie. Dzięki swojej elastyczności jest szeroko stosowany w edukacji oraz zaawansowanych badaniach naukowych.”

„NEURON to oprogramowanie symulacyjne używane do modelowania biologicznych neuronów i sieci neuronowych. Jest szczególnie przydatne w neurobiologii do badania przepływu prądu w pojedynczych neuronach, jak i w bardziej złożonych strukturach, takich jak obwody neuronalne. NEURON pozwala na tworzenie modeli w oparciu o rzeczywiste właściwości biofizyczne komórek nerwowych.

Oprogramowanie zostało opracowane przez Michaela Hinesa z Uniwersytetu Yale i Johna Moore’a z Duke University w latach 90. XX wieku. NEURON obsługuje zarówno symulacje czasowe, jak i przestrzenne, oferując dużą precyzję w badaniach nad sygnałami neuronowymi. Jest szeroko stosowane w badaniach naukowych nad funkcjonowaniem układu nerwowego oraz w rozwijaniu narzędzi dla sztucznej inteligencji inspirowanej biologią. Dzięki otwartemu charakterowi i szerokim możliwościom personalizacji, NEURON jest podstawowym narzędziem w nowoczesnej neuroinformatyce.”

Obie te w/w technologie należą do mafii. I po co to piszę? Ludzkość jako masa jest jakieś -30 lat albo więcej, wstecz względem najnowszych osiągnięć technologicznych, którymi posługuje się przeciw nam czarna szlachta. Nawet CERN. Mafijna rodzina E.-O. prowadzi CERN z F. G. jako dyrektorem generalnym CERN, który jest używany do generowania ciśnienia w niższych warstwach atmosfery w celu wywierania stałego nacisku na umysły społeczeństw UE. Podsumowując to tak jakbyśmy teraz w 2024 używali technologii z 1990 roku.